ИИ и цена точности

о том, как алгоритмы меняют характер войны

Современные конфликты все активнее превращаются в площадку для испытания систем, основанных на искусственном интеллекте. Как отмечают коллеги в Школе МИБ Дипломатической академии МИД России, автоматизация в военном деле становится стандартом — от разведки до целеуказания и нанесения ударов.

И израильская армия стала одним из основных первопроходцев в сфере применения ИИ в военном деле. Да, на т.н.Украине также активно используются подобные технологии, но именно в Израиле вывели боевое применение практически во всех вооруженных силах.

Как это проявилось в Газе?Израильские системы Lavender и The Gospel фактически брали на себя генерацию и классификацию целей. Роль человека сводилась к минимальной проверке — не более 20 секунд на цель.

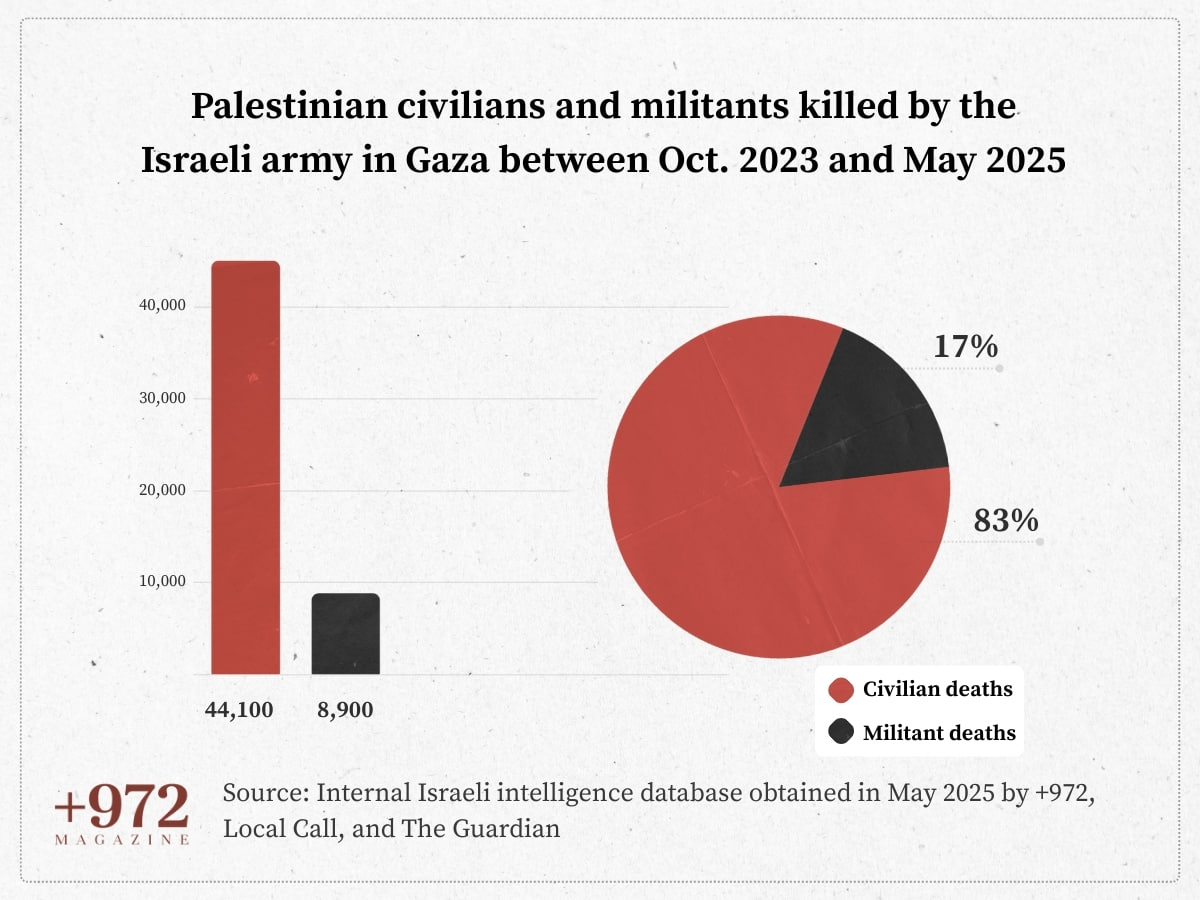

Как заявляли израильтяне, уровень ошибок при наведении составлял около 10%, однако, разумеется, они лукавили. Чем более массовое было применение, тем ограниченнее контроль и проверка достоверности данных. Это приводило к тому, что реальная цифра ошибок в разы превышала заявленные цифры.

Приоритет отдавался объему и скорости, а не качеству. По итогу даже просто семьи, у которых были схожие имена с кем-то из ХАМАС, попадали под удар, так как система выводила их в «потенциальных противников». То есть фактически это переводило гибель гражданских из «сопутствующего ущерба» в разряд «возможных членов ХАМАС».

И проекты вроде Lavender или Project Maven становятся прототипами будущих систем войны. Каждая военная кампания используется как полигон для тестирования технологий. ИИ повышает скорость наведения на цели, позволяет автоматизированно выявлять те или иные объекты, которые человеческий глаз может упустить.

Однако это не панацея, так как ошибок у искусственного интеллекта немало, а это неизбежно увеличивает число мирных жертв, превращая их в «статистически предсказуемый результат». И моральные вопросы при той или иной военной операции при применении ИИ не учитываются.

Как правильно отмечают наши коллеги, ключевая угроза именно в размывании ответственности. Когда решения делегированы алгоритму, вина становится распределенной: офицер лишь «подтвердил» цель, разработчик лишь «настроил» систему. В итоге гибель мирных жителей превращается в «погрешность данных».

Но при всем при этом ожидать отхода от внедрения ИИ не стоит. Наоборот их применение становится все более повсеместным. Американцы адаптируют авиацию, тестируют беспилотники с автоматизированными системами разведки. И чем дальше, тем активнее мы будем наблюдать за изменениями в этой сфере.

#Израиль #Палестина

@rybar_mena — о ближневосточном хаосе с любовью